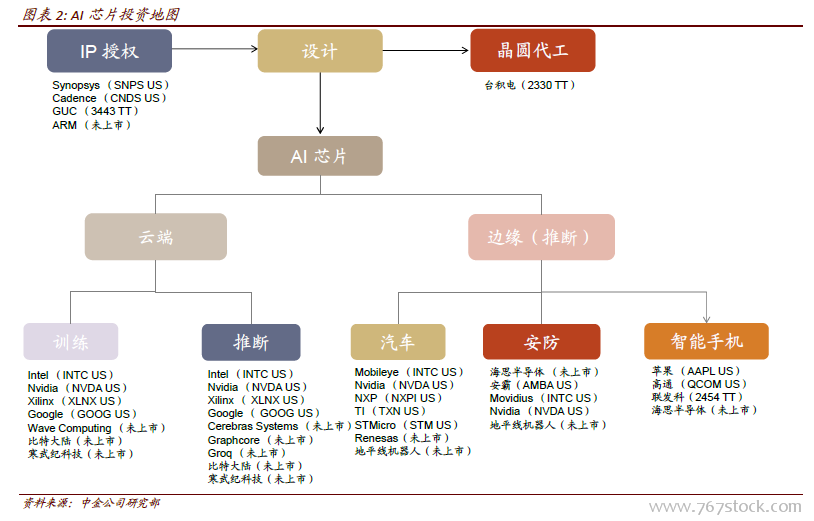

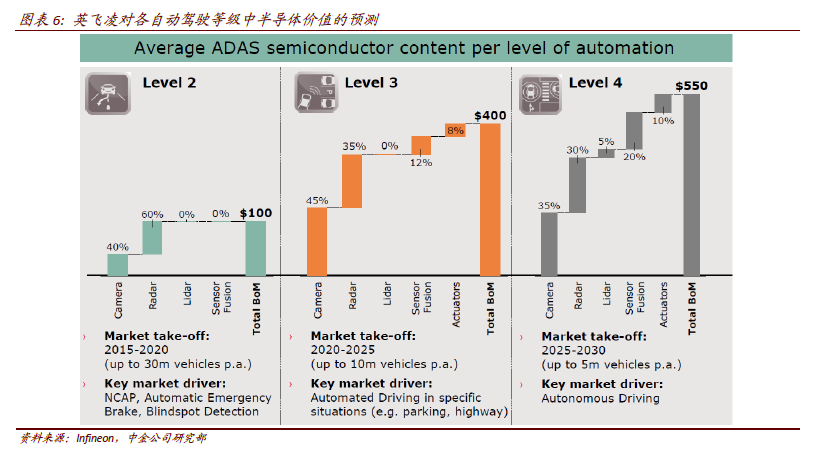

新品競相發布,AI 芯片行業格局漸趨明朗。AI 芯片設計是人工智能產業鏈的重要一環。自2017 年5 月以來,各AI 芯片廠商的新品競相發布,經過一年多的發展,各環節分工逐漸明顯。AI 芯片的應用場景不再局限于云端,部署于智能手機、安防攝像頭、及自動駕駛汽車等終端的各項產品日趨豐富。除了追求性能提升外,AI 芯片也逐漸專注于特殊場景的優化。

AI 芯片市場規模:未來五年有接近10 倍的增長,2022 年將達到352 億美元根據我們對相關上市AI 芯片公司的收入統計,及對AI 在各場景中滲透率的估算,2017年AI 芯片市場規模已達到39.1 億美元。

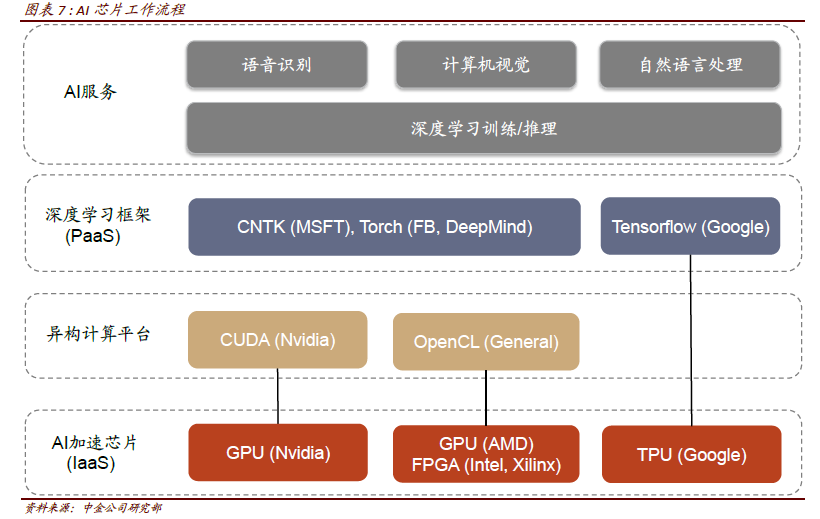

云端訓練芯片:TPU 很難撼動Nvidia GPU 的壟斷地位。訓練是指通過大量的數據樣本,代入神經網絡模型運算并反復迭代,來獲得各神經元“正確”權重參數的過程。CPU 由于計算單元少,并行計算能力較弱,不適合直接執行訓練任務,因此訓練一般采用“CPU+加速芯片”的異構計算模式。目前Nvidia 的GPU+CUDA計算平臺是最成熟的AI 訓練方案。

Nvidia GPU 在云端訓練芯片中占據領導者地位。GPU 最初只服務于圖形處理加速,為了使GPU 能夠更好地用于通用計算,Nvidia 開發了CUDA 計算平臺。CUDA 對各種主流學習框架的兼容性最好,成為Nvidia 的核心競爭力之一。目前Nvidia GPU 已發展到第六代Volta架構,5120 個CUDA 核心提供了超120 TFLOPS 深度學習算力,帶寬高達900GB/s,以其優異的性能繼續在全球領先。

在GPU 之外,云端訓練的新入競爭者是TPU。Google 在去年正式發布了其TPU 芯片,并在二代產品中開始提供對訓練的支持,但比較下來,GPU 仍然擁有最強大的帶寬(900GB/s,保證數據吞吐量)和極高的深度學習計算能力(120 TFLOPS vs. TPUv2 45 TFLOPS),在功耗上也并沒有太大劣勢(TPU 進行訓練時,引入浮點數計算,需要逾200W 的功耗,遠不及推斷操作節能)。目前TPU 只提供按時長付費使用的方式,并不對外直接銷售,市占率暫時也難以和Nvidia GPU 匹敵。